Lichtfeldkameras

Ein Lichtfeld ist ein 4D-Datensatz der ein hohes Potential bietet um die Perzeption zukünftiger Roboter zu verbessern. Im Vergleich zu herkömmlichen 2D Bildern besitzt ein 4D-Lichtfeld zwei zusätzliche Dimensionen. Dadurch ist es möglich zahlreiche zusätzliche Informationen zu erhalten und verschiedene Datenprodukte abzuleiten. Hierbei sind auf einen bestimmten Abstand fokussierte 2D-Bilder sowie 3D-Tiefenbilder die am häufigsten verwendeten Datenformate. Wir untersuchen die Verarbeitung und Verwendung von Lichtfelddaten für robotische Systeme unter Berücksichtigung der oftmals limitierten Ressourcen und der begrenzt verfügbaren Rechenzeit. Da Lichtfelder heutzutage am effizientesten mit plenoptischen Kameras, einer neue Art von Kamera, aufgenommen werden können, untersuchen wir zudem die Kalibrierung aber auch die generellen Eigenschaften dieser neuen Sensorklasse. Dies ermöglicht es uns, die Qualität und die Genauigkeit der aufgenommenen Daten zu verbessern.

Das Lichtfeld

Ein Lichtfeld enthält, im Gegensatz zu normalen Bildern, nicht nur die Lichtintensität an der Position an der ein Lichtstrahl auf den Kamerasensor trifft, sondern auch die Richtung aus der der Lichtstrahl eintrifft. Die Intensität, d.h. die vom Sensor gemessene Lichtmenge, an Position (u, v) und für die Richtungswinkel (θ, φ) sind die Informationen die ein 4D-Lichtfeld bilden. Ein normales 2D Bild, d.h. ein Datensatz der Lichtintensitäten auf dem Sensor an den Stellen (u,v), kann aus einem 4D-Lichtfeld mittels Rendering erstellt werden. Dank der zwei zusätzlichen Dimensionen sind weitere Datenprodukte möglich. Die am häufigsten verwendeten sind 2D Bilder die z.B. auf einen bestimmten Abstand fokussiert wurden oder die einen erweiterten Tiefenschärfebereich aufweisen. Auch die Erstellung von 3D Tiefenbildern ist aus 4D-Lichtfeldern möglich.

Wir untersuchen die vielfältigen Nutzungsmöglichkeiten von Lichtfeldern für robotische Anwendungen unter dem Aspekt, dass es nun möglich ist mit einer einzigen Aufnahme mehrere direkt miteinander verwandte Datenprodukte zu erzeugen, z.B. hochaufgelöste 3D Tiefenbilder und 2D Bilder. Aufgrund der vier Dimensionen von Lichtfeldern benötigt deren Prozessierung zur Zeit einen relativ hohen Rechenaufwand. Um diese Daten für Roboter, deren Rechenleistung und Zeit für Berechnungen oftmals stark begrenzt sind, nutzbar zu machen, untersuchen wir neue Möglichkeiten um die Effizienz aber auch die Qualität der Lichtfeldverarbeitung zu verbessern.

Plenoptische Kameras

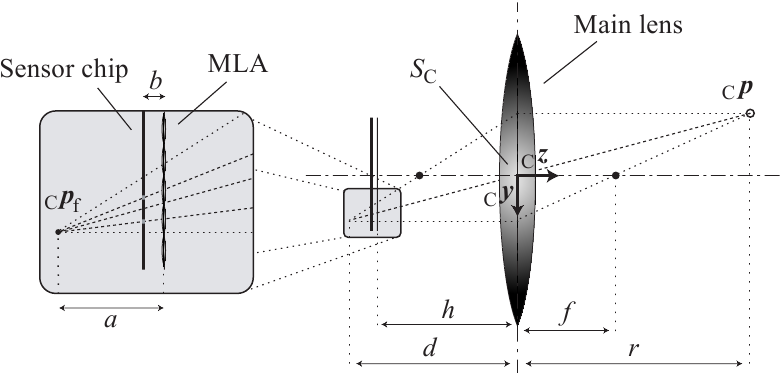

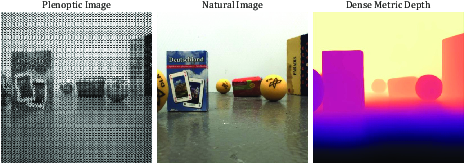

Lichtfelder werden heutzutage am besten mit plenoptischen Kameras aufgenommen, die durch die Modifizierung herkömmlicher Kameras erreicht werden können. Diese Kameras haben neuartige Eigenschaften, die es ermöglichen mittels einer einzigen Kamera passive hochaufgelöste Tiefenmessungen durchzuführen. Bei einer plenoptischen Kamera wird eine Platte mit Mikrolinsen (engl. Micro Lense Array, kurz MLA) vor dem Kamerasensor montiert (s. Abb. 1).

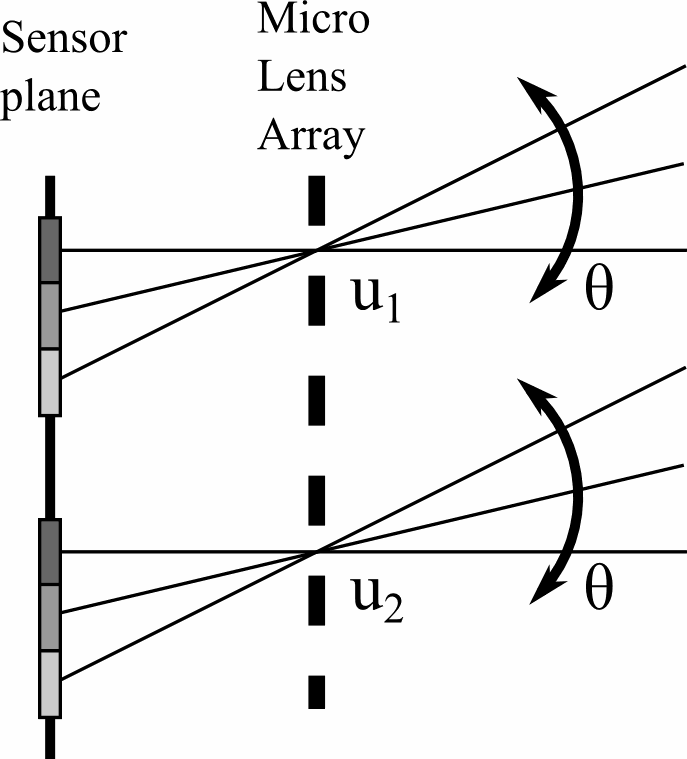

Das MLA ist eine Matrix aus einzelnen Mikrolinsen, jede mit einem Durchmesser von einigen Mikrometern. Der Sichtbereich einer Mikrolinse umfasst dabei einige hundert Pixel. Eine Mikrolinse bricht einen einfallenden Lichtstrahl, so dass er je nach Einfallsrichtung auf einen bestimmten Pixel unterhalb der Mikrolinse fällt. Dadurch werden die vier Dimensionen eines Lichtfelds aufgenommen, d.h. die Position (u,v) entspricht einer Mikrolinse und die Richtungswinkel (θ, φ) entsprechen einem Pixel unter dieser Mikrolinse wie in Abb. 2 gezeigt.

Da in der robotischen Bildverarbeitung Kameras als Messsysteme verwendet werden ist es unter anderem notwendig metrische Informationen aus Lichtfelddaten zu gewinnen. Daher untersuchen wir die Kalibrierung sowie die generellen Eigenschaften von plenoptischen Kameras um die Qualität und die Genauigkeit der aufgenommenen Daten zu verbessern.

Kalibrierung plenoptischer Kameras

Kommerziell erhältliche plenoptische Kameras liefern momentan Abstandswerte in nicht-metrischen Einheiten, was eine Hürde für neue Anwendungen z.B. in der Robotik darstellt. Wir haben daher einen neuen Ansatz entwickelt, der die traditionellen Methoden der Kamerakalibrierung nutzt, um den Ablauf der Kalibrierung plenoptischer Kameras zu vereinfachen und um die Genauigkeit zu erhöhen.

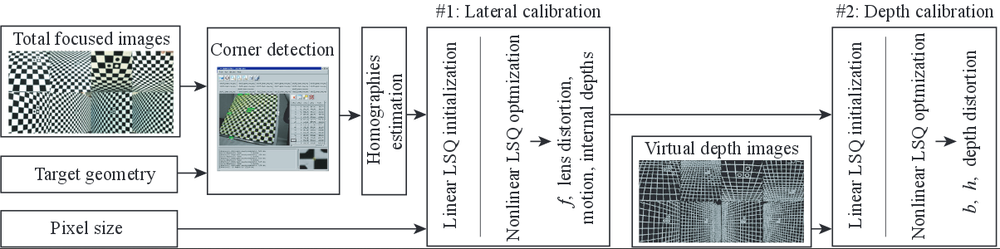

Das Kalibrierverfahren verwendet eine Reihe von Bildern eines bekannten Kalibriermusters genau wie bei der Standardkalibriermethode für Lochkameras (s. DLR CalDe und DLR CalLab).

Allerdings trennt der Kalibrieralgorithmus die Kalibrierung der traditionellen Eigenschaften plenoptischer Kameras von der Kalibrierung der neuartigen, plenoptischen Eigenschaften in Bezug auf die Tiefenschätzung wie in Abb. 3 gezeigt.

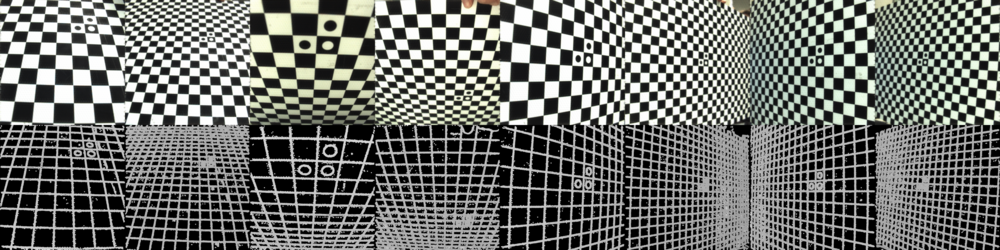

Diese beiden Schritte der Kalibrierung werden daher auch mit zwei unterschiedlichen Eingangsdatentypen durchgeführt die beide aus dem 4D-Lichtfeld einer Aufnahme erzeugt werde Diese sind zum einen 2D-Bilder mit einem erweiterten Tiefenschärfenbereich und zum anderen 3D-Tiefenbildern, s. Abb. 4.

Durch diese Trennung beeinflussen die übergeordneten Rauschanteile aus der Tiefenschätzung nicht mehr die Schätzung der traditionellen Parameter wie Brennweite oder radiale Linsenverzerrung. Zudem ergeben sich weitere Vorteile durch diese getrennte Kalibrierung. Erstens können nun unterschiedliche Optimierungen auf die oben genannten Eingangsdaten angewendete werden, die es ermöglichen die für den jeweiligen Datentyp spezifischen Ausreißer gezielter zu reduzieren. Zweitens sind die zwei Teile der Kalibrierung einfacher, wodurch neuartige, schnellere Initialisierungsmodelle für alle Parameter möglich werden. Wobei die einzig benötigten Hardwareparameter die Größe der Sensorpixel und die lokale Geometrie des Kalibrationsmusters sind. Drittens wird so eine Vermischung der entsprechenden Modelle für die Linsen- und Tiefenverzeichnung und für die inneren Größen Brennweite f, Abstand b zwischen MLA und Sensor sowie Abstand h zwischen MLA und Hauptlinsenebene während der Optimierung verhindert (s. Abb. 1 für Bezeichnungen).

Die Genauigkeit der Ergebnisse aus der Kalibrierung bestätigen unsere Überzeugung, dass die monokulare plenoptische Aufnahmetechnik eine umwälzende Technologie ist die es ermöglichen wird neue Anwendungsbereiche zu erschließen sowie die traditionelle Aufnahmetechnik weiterzuentwickeln.

Metrische Tiefenschätzung aus einem Bild

Die Lichtfeldabbildung ist eine vielversprechende Lösung für die Schätzung der metrischen Tiefe durch die Verwendung einer einzigen Linsenkonfiguration und einen einzigen Sensor. Die Anwendung dieser Technologie auf die Gewinnung dichter metrischen Tiefenbilder ist jedoch noch nicht ausreichend erforscht, was vor allem an den hohen Kosten, dem Mangel an öffentlichen Benchmarks und proprietären geometrischen Modellen und Software liegt.

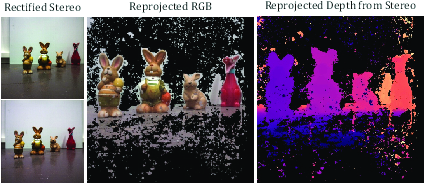

Wir haben das Potenzial von fokussierten plenoptischen Kameras für eine dichte metrische Tiefenschätzung untersucht und eine neuartige Pipeline vorgeschlagen, die die metrische Tiefe aus einer einzigen plenoptischen Kameraaufnahme schätzt, indem sie zunächst eine spärliche metrische Punktwolke mit Hilfe von maschinellem Lernen erzeugt, die dann verwendet wird, um eine dichte relative Tiefenkarte zu skalieren und auszurichten, die durch ein Foundation Depth Model geschätzt wird, wodurch eine dichte metrische Tiefe entsteht.

Zur Validierung haben wir den Light Field & Stereo Image Dataset (LFS) kuratiert, der reale Lichtfeldbilder mit Stereotiefenbeschriftungen enthält und eine Lücke in den vorhandenen Ressourcen schließt.

Ausgewählte Veröffentlichungen

B. Lasheras-Hernandez, K. H. Strobl, S. Izquierdo, T. Bodenmüller, R. Triebel, and J. Civera. Single-Shot Metric Depth from Focused Plenoptic Cameras. Proceedings of the IEEE International Conference on Robotics and Automation (ICRA 2025), Atlanta, GA, USA, May 19-23 2025. [elib]

B. Lasheras-Hernandez, K. H. Strobl, and T. Bodenmüller. The Light Field & Stereo (LFS) Image Dataset. Zenodo, Nov 28 2024. https://doi.org/10.5281/zenodo.14224205 [elib]

M. Lingenauber, U. Krutz, F. A. Fröhlich, Ch. Nißler, and K. H. Strobl. In-Situ Close-Range Imaging with Plenoptic Cameras. Proceedings of the 2019 IEEE Aerospace Conference, Big Sky, MT, USA, March 2-9 2019, https://doi.org/10.1109/AERO.2019.8741956.

M. Lingenauber, U. Krutz, F. A. Fröhlich, Ch. Nißler, and K. H. Strobl. Plenoptic Cameras for In-Situ Micro Imaging (poster). Proceedings of the European Planetary Science Congress 2018, Berlin, Germany, September 16-21 2018.

U. Krutz, M. Lingenauber, K. H. Strobl, F. Fröhlich, and Maximilian Buder. Diffraction Model of a Plenoptic Camera for In-Situ Space Exploration (poster). Proceedings of the SPIE Photonics Europe 2018 Conference, Volume 10677, Straßburg, France, April 24-26 2018.

M. Lingenauber, K. H. Strobl, N. W. Oumer, and S. Kriegel. Benefits of Plenoptic Cameras for Robot Vision during Close Range On-Orbit Servicing Maneuvers. Proceedings of the 2017 IEEE Aerospace Conference, Big Sky, MT, USA, March 4-11 2017, pp. 1-18, https://doi.org/10.1109/AERO.2017.7943666.

K. H. Strobl and M. Lingenauber. Stepwise Calibration of Focused Plenoptic Cameras. Computer Vision and Image Understanding (CVIU), Volume 145, April 2016, pp. 140-147, ISSN 1077-3142, http://dx.doi.org/10.1016/j.cviu.2015.12.010.