PSPE (2004)

Nutzlastunterstützung für die Planetenerkundung

Die autonome Erkundung von Planeten wird bei zukünftigen Weltraummissionen eine wichtige Rolle spielen. Daher haben wir im Rahmen mehrerer ESA-Verträge (ROBUST, PSPE, ROSA-M) die Machbarkeit der robotisierten Planetenerkundung untersucht. Im Rahmen des europäischen Projekts Payload Support for Planetary Exploration (PSPE) haben wir ein Konzept für die Konfiguration und Steuerung von Lander-Raumfahrzeugen vorgeschlagen, das es ermöglichen sollte, geowissenschaftliche Operationen auf dem Mars durchzuführen, allerdings mit einer höheren lokalen Autonomie als z.B. der Sojourner-Rover des Pathfinders.

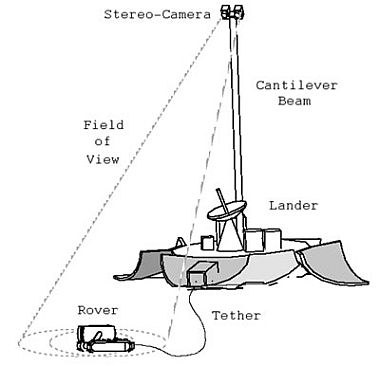

Das vorgeschlagene On-Orbit-System besteht aus den folgenden Komponenten:

- Das Lander-System (siehe daneben) trägt die gesamte Versorgungstechnik und das komplette Kontrollsystem für den Rover, die wissenschaftliche Instrumentierung und die Kommunikation mit der Bodenkontrollstation.

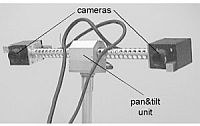

- Der Imaging Head (siehe unten), der auf einem vertikalen Ausleger montiert ist, ist mit einer weltraumtauglichen Stereokamera und mit einer Schwenk- und Neigeeinheit mit zwei Freiheitsgraden ausgestattet. Die Kameras sind sowohl für die Aufnahme von stereoskopischen Panoramabildern des Landeplatzes als auch für die Erkennung von interessanten Objekten in der Umgebung des Landers optimiert.

- Der Nanokhod Rover (siehe unten) ist ein robuster, einfacher, zuverlässiger und dennoch effektiver, raupengetriebener Träger wissenschaftlicher Ausrüstung, der dafür optimiert ist, interessante Punkte in der Umgebung des Landers anzufahren und in situ Messungen durchzuführen. Über ein Strom- und Datenkabel mit dem Lander verbunden, profitiert der Nanokhod von der Versorgungstechnik des Landers.

Aufgrund der sehr großen Zeitverzögerung zwischen Boden- und Raumsegment (Übertragungszeit von mehr als 20 Minuten in Bezug auf das Mars-Szenario) und der typischen Beschränkungen der Kommunikationsbandbreite im Weltraum ist eine Online-Kontrolle nicht möglich. Das bedeutet, dass der Rover auf einer sehr abstrakten Ebene kommandiert werden muss: Das Bodenkontrollsystem bietet eine einfach zu bedienende Kommandoschnittstelle, die für die intuitive Unterstützung wissenschaftlicher Experimente optimiert ist, ohne dass spezielle Robotikkenntnisse erforderlich sind. Es basiert auf einem Geländemodus, der während der Erkundung des Geländes aus den stereoskopischen Panoramabildern vor Ort rekonstruiert wird. Ein Missionsspezialist wählt im Geländemodell interessante Orte oder Objekte aus, die vom Nanokhod - dem "langen Arm" des Landers - erkundet werden sollen. Ein ausgeklügelter Pfadplanungsalgorithmus bestimmt den optimalen Pfad unter Berücksichtigung gegebener Randbedingungen (z.B. Topographie, geschätzter Boden und bekannte Fahreigenschaften des Rovers). In unserem Ansatz wird eine Liste von Wegpunkten, die vom Pfadplaner am Boden bestimmt wurde, in das Raumsegment hochgeladen, um vor Ort autonom ausgeführt zu werden.

Für die Machbarkeitsstudie haben wir einen bildverarbeitungsbasierten Ansatz für die präzise Lokalisierung und Führung des Rovers vorgeschlagen und umgesetzt. Das Bildverarbeitungs- und 3D-Lokalisierungssystem des genannten Bildverarbeitungskopfes erkennt signifikante Merkmale des Rovers in den Stereobildern, bestimmt die aktuelle Position des Rovers in Bezug auf ein Referenzsystem und steuert die Bewegung des Rovers, um die gewünschte Zielposition zu erreichen. Um die Erkennung von Merkmalen zu erleichtern, sind 4 LEDs auf der Oberseite der Nutzlastkabine des Rovers angebracht. Mithilfe eines einfachen Blob-Finding-Algorithmus, der auf die Differenzbilder (LED ausgeschaltet/eingeschaltet) angewendet wird, können die 2D-Koordinaten der LEDs in der Bildebene berechnet werden. Um die Position des Rovers zu bestimmen, erzeugt ein Algorithmus zur Stereorekonstruktion zunächst 3D-Punkte, die den gegebenen Paaren von 2D-Bildkoordinaten entsprechen. Anschließend wird ein Algorithmus angewendet, der diese "gemessenen" 3D-Punkte mit den "modellierten" abgleicht, um die Transformation zwischen dem Rover und dem Kamerasystem zu erhalten. Die erfolgreiche Überprüfung wurde nicht nur auf dem Planetenprüfstand der ESA demonstriert, sondern auch auf einem speziell entwickelten Modell der Marsoberfläche im Institut.

Das ursprünglich für Weltraummissionen entwickelte System lässt sich leicht an Anwendungen auf der Erde anpassen, z.B. für die Steuerung mobiler Roboter in rauen und gefährlichen Umgebungen.

Ähnlicher Artikel: Ein Mikro-Rover-Navigations- und Kontrollsystem für die autonome Erkundung von Planeten (siehe Downloads)