Robotic Work Cell Exploration

Aufgabenstellung

Der am Institut für Robotik und Mechatronik entwickelte Multisensorielle 3D-Modellierer (3DMo) erfasst 3D-Daten über seine Umgebung. Dieses Gerät besteht aus einem passiven Manipulator mit sieben Freiheitsgraden, der mit vier verschiedenen Sensorarten bestückt ist: einem Lichtschnittsensor, ein Laserentfernungsscanner, einem passiven Stereokamerasensor und einem Sensor für die Oberflächentextur. Die bei der Entwicklung dieses passiven Eye-in-Hand-Systems gewonnenen Erfahrungen führten zu der Idee, die Durchführung von Inspektionsaufgaben zu automatisieren. Das Ergebnis ist ein Robotersystem, das in der Lage ist, automatisierte Inspektionsaufgaben wie die vollständige Erfassung von (Ober-)Flächen in dreidimensionalen Umgebungen durchzuführen. Da sich der Roboter in zuvor unbekannte Umgebungen hineinbewegt, ist es für die Oberflächenerfassung von wesentlicher Bedeutung, dass der Roboter Kenntnisse über den Raum sammelt, der zum Manövrieren genutzt werden kann. Dieser Raum ist der Konfigurationsraum, oder auch C-Space, und muss insbesondere um das zu inspizierende Objekt herum exploriert werden. Der Ansatz, realistische, rauschbehaftete Sensormodelle in die View-Planning-Phase zu integrieren, entstand in diesem Zusammenhang. Die Informationen über das Sensorrauschen können für das Zusammenführen mehrerer Messwerte genutzt werden, um widersprüchliche Datensätze zu vermeiden und Hinweise für den nächsten Erfassungsvorgang durch den Roboter zu geben.

Methoden

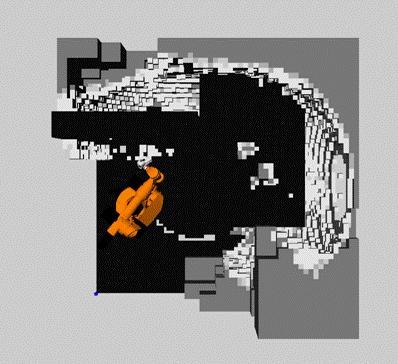

Ein Schwerpunkt der Arbeiten am Robotics Lab der Simon Fraser University in Kanada liegt auf der sensorbasierten Bewegungsplanung für Roboter mit nicht-trivialer Geometrie und Kinematik. Die Aufgabe besteht hier darin, den Next Best View (beste nächste Kameraaufnahme, NBV) zu planen, um den Konfigurationsraum des Roboters möglichst effizient zu erkunden. Der Begriff der C-Space-Entropie wurde als Maß der Unkenntnis des Konfigurationsraums entwickelt. Danach wird der NBV so gewählt, dass die erwartete Entropie über den Konfigurationsraum um das größtmögliche Maß reduziert wird.

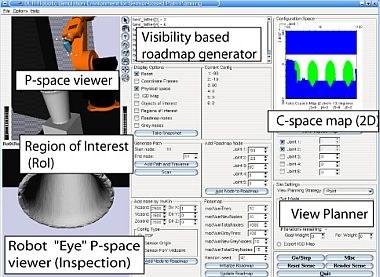

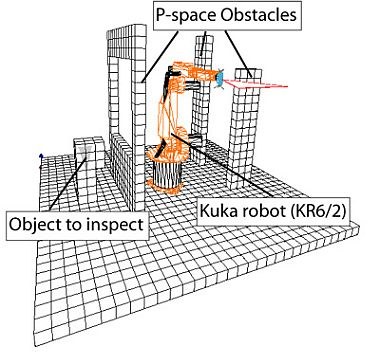

Die Forschung konzentriert sich auf sensorbasierte Ansätze zur robotergestützten Erkundung von teilweise unbekannten Umgebungen. Mit dem Ziel, automatisierte Arbeitsprozesse in flexiblen Arbeitszellen zu ermöglichen, wird eine effiziente und zuverlässige aufgabenabhängige Exploration durchgeführt durch die Integration von flexiblen Sensorsystemen, probabilistische Umgebungsrepräsentationen, eine Perspektiv- und Bewegungsplanung, die darauf ausgelegt ist, mit einer minimalen Anzahl von Perspektiven ein Maximum an Wissen zu erlangen, und die Fusion von Informationen. Sicherheit für die Bewegungsplanung wird durch multisensorische Datenerfassung erreicht. Die vorgeschlagenen Methoden und Sensoren werden in 3D-Simulationen evaluiert. Experimente zur Erkundung des Arbeitsraums, von Interessengebieten im physischen Raum und kombinierte Missionen werden erfolgreich durchgeführt. Die Methoden, die die Unsicherheit der Umgebung im Planungsprozess berücksichtigen, ermöglichen flexible, auf Informationsgewinn ausgerichtete Missionen, wie z.B. die Planung der Perspektive zur Objekterkennung oder die Planung des Greifens.

In der erwähnten Arbeit wurde allerdings von einem idealen Sensormodell ausgegangen, während reale Sensoren sehr oft rauschbehaftet sind. Daher können die Ergebnisse dieses idealen Erfassungsprozesses nur mit Vorsicht verwendet werden, so müssen z.B. die Sicherheitsabstände zu Hindernissen vergrößert werden. Allerdings würden unsere Ergebnisse sehr viel genauer und zuverlässiger sein, wenn wir das Sensorrauschen bereits in der Planungsphase modellieren. So kann sich der Roboter sehr viel näher an die Hindernisse heranbewegen, um eine hohe Messgenauigkeit zu erreichen, was für die Prüfung von Oberflächen unverzichtbar ist. Darüber hinaus können bei Einsatz mehrerer Sensoren für die Exploration dieselben stochastischen Sensorrauschmodelle nicht nur zum Zusammenführen mehrerer Messwerte verwendet werden, sondern auch für Entscheidungen in Bezug auf das View Planning und die Exploration – z.B. in welche Richtung und mit welchem Sensor erfasst wird – um so ein einzelnes integriertes Framework zu schaffen.

Ergebnisse

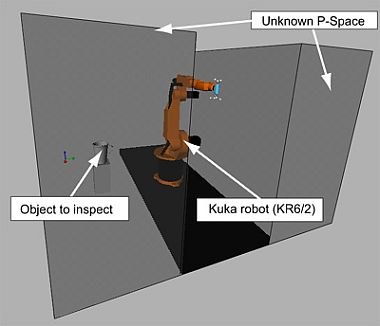

Simulationen mit einem zweigliedrigen Roboter zeigten vielversprechende Ergebnisse und es wird zurzeit eine Simulationsumgebung für Roboter mit n Freiheitsgraden entwickelt. Um den Speicherbedarf zu verringern, wird eine sichtbasierte Roadmap implementiert. Der verwendete Roboter ist ein Kuka KR6 mit 6 Freiheitsgraden und einer neuen Version des Multisensoriellen 3D-Modellierers, der handgeführt oder am Roboter einsetzbar ist. Mehrere Ansätze zum View Planning zeigen bereits gute Explorationsergebnisse in 3D. Nachfolgend sind der Versuchsaufbau skizziert und die Ergebnisse der Exploration dargestellt.

Veröffentlichungen

- M. Suppa, Autonomous Robot Work Cell Exploration Using Multisensory Eye-in-Hand Systems, Hochschulschrift: Hannover, Univ., Dissertation, 2007 [elib] (Parallel als Buch-Ausgabe erschienen: Fortschritt-Berichte VDI Reihe 8, Mess-, Steuerungs- und Regelungstechnik; Nr. 1143, ISBN: 978-3-18-514308-3).

- R. Burger, Anbindung und Evaluierung von Sensorik zur Erzeugung von Umgebungsmodellen in Robotersteuerungen, Technical Report, DLR-IB 515-2007/15, 2007.

- T. Bodenmueller, W. Sepp, M. Suppa, and G. Hirzinger, Tackling Multisensory 3D Data Acquisition and Fusion, In: Proceedings of the 2007 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS), San Diego, U.S.A., 2007.

- M. Suppa, S. Kielhoefer, J. Langwald, F. Hacker, K. H. Strobl, and G. Hirzinger, The 3D-Modeller: A Multi-Purpose Vision Platform, In: Proceedings of International Conference on Robotics and Automation (ICRA), Rome, Italy, 2007.

- M. Suppa and G. Hirzinger, Multisensorielle Exploration von Roboterarbeitsraeumen, TM-Technisches Messen, 2007, Vol. 74[3], pages 139-146, 2006.

- M. Suppa and G. Hirzinger, Multisensorielle Exploration von Roboterarbeitsraeumen, In: Informationsfusion in der Mess- und Sensortechnik, J. Beyerer, F. Puente Leon, and K.-D. Sommer (Hrsg.), 2006.

- M. Suppa and G. Hirzinger, Ein Hand-Auge-System zur multisensoriellen Rekonstruktion von 3D-Modellen in der Robotik, In: at-Automatisierungstechnik, Vol. 53[7], pages 323-331, 2005.

- M. Suppa and G. Hirzinger, A Novel System Approach to Multisensory Data Acquisition, In: Proceedings of the 8th Conference on Intelligent Autonomous Systems IAS-8, Amsterdam, The Netherlands, 2004.

- M. Suppa, P. Wang, K. Gupta, and G. Hirzinger, C-space Exploration Using Noisy Sensor Models, In: Proceedings of the International Conference on Robotics and Automation ICRA 2004, pages 4777-4782, New Orleans, U.S.A., 2004.

- Wang, P., Gupta, K., View Planning via Maximal C-Space Entropy Reduction, Fifth International Workshop on Algorithmic Foundations of Robotics WAFR 2002, Nice, France, 2002.