Erklärbare künstliche Intelligenz in der Robotik

Wie viel wissen die Roboter am DLR-Institut für Robotik und Mechatronik darüber, was sie tun und warum? Um das herauszufinden, hat Freek Stulp – Abteilungsleiter für Kognitive Robotik – die "Green Button Challenge" ins Leben gerufen. Im Rahmen des DLR Blogs berichtet er von seinen Erfahrungen:

Robotik ist eng mit dem Thema Künstliche Intelligenz (KI) verknüpft. Roboter werden schließlich gebaut, um etwas zu tun – und damit sie wissen was zu tun ist und wie, brauchen sie nun mal eine gewisse Intelligenz. Das große Interesse an der KI in den letzten Jahren ist vor allem durch datengetriebene Methoden entstanden, besonders durch das sogenannte "Deep Learning". Durchbrüche in diesem Bereich – zum Beispiel ihre erfolgreiche Anwendung in der Sprach- oder Bilderkennung – wurden möglich, weil jetzt große Datenmengen und mehr Rechenkapazitäten zur Verfügung stehen.

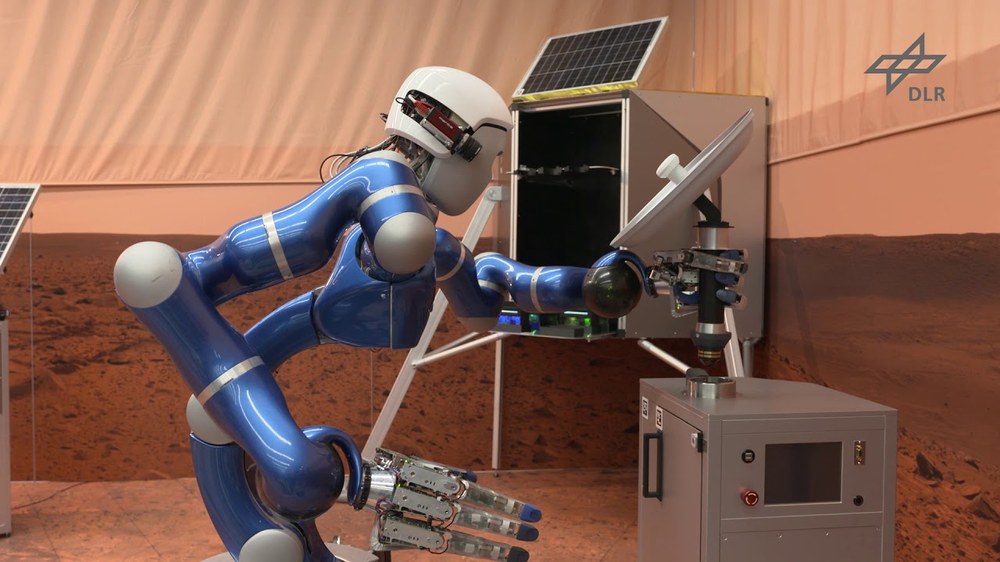

Solche Deep Learning Methoden erkennen zum Beispiel ein Solarpaneel oder einen Löffel in einem Bild, weil sie Muster aus dem Bild extrahieren, die typisch sind für Solarpaneele oder Löffel. Das Erkennen an sich bedeutet aber nicht, dass ein Roboter weiß, dass man Löffel zum Essen verwendet – und auch nicht, wie man Löffel am besten greift, um sie dafür zu benutzen. Für einen Roboter auf dem Mond oder Mars ist es nicht nur nützlich, Solarpaneele zu erkennen, sondern auch zu wissen, dass er dort seinen Akku aufladen kann. Ein Roboter, der die Funktion von Objekten nicht kennt, kann nicht wissen, was er tut.

Die "Green Button Challenge"

Um herauszufinden, welche Roboter am Institut

für Robotik und Mechatronik wissen, was sie tun und warum, habe ich meine Abteilung für kognitive Robotik vor eine Herausforderung gestellt: Innerhalb von einer Woche sollte neben ausgewählten Robotern ein grüner Knopf bereit stehen. Wenn ich auf diesen Knopf drücke, soll mir der Roboter erklären, was er gerade macht. Und wenn ich nochmals drücke, möchte ich von ihm hören, warum. Fünf Teams haben diese "Green Button Challenge" angenommen. Bei einigen Robotern war das Wissen darüber, was sie tun, schon relativ gut im Computer-Programm repräsentiert. Es musste nur noch "ausgesprochen" werden. Bei anderen Robotern war das Wissen eher implizit und uneinheitlich vorhanden. In diesen Fällen hatten die Programmierer dem Roboter zwar vorgegeben, wie etwas zu tun ist (zum Beispiel genaue Bewegungen, die nötig sind, um eine Flasche zu greifen), aber nicht explizit im Programm beschrieben, was zu tun ist oder warum (zum Beispiel dass die Flasche gegriffen wird, um danach Wasser in eine Tasse einzuschenken). Bei diesen Robotern das "Was" und "Warum" einzuprogrammieren, war also mehr Arbeit. Nach einer Woche intensiven Nachdenkens und Programmierens stellten die einzelnen Teams ihre Green-Button-Lösung vor.

Damit alle Roboter die generierten Sätze auch aussprechen konnten, hat eines der Teams einen Deep Learning Ansatz dafür implementiert und allen anderen Teams zur Verfügung gestellt. Deep Learning ist für diese Art von Aufgabe unschlagbar.

Die Roboter fangen an zu erklären

Zunächst war es auch für uns Forscher ungewohnt und beeindruckend, dass unsere Roboter buchstäblich auf Knopfdruck anfingen zu erklären, was sie da machten. Einer der Roboter hat zum Beispiel kaum aufgehört, über eines seiner Gelenke zu plappern! Schließlich hat das Team um unseren Rollin' Justin den Wettbewerb gewonnen, weil Justin ausführlich und vielschichtig darüber berichten konnte, was er gerade macht und welches vorgegebene Ziel er damit erreichen will.

Justin war zum Beispiel damit beschäftigt, ein Solarpaneel zu drehen, als jemand auf den grünen Knopf drückte. "I want to execute action rotate solar panel 1", erklärte Justin. Nächster Knopfdruck: "Because I want to have solar panel 1 in a different orientation" – Knopfdruck – "Because I want to execute action clean solar panel 1" – Knopfdruck – "Because I want to have a clean solar panel". Frei übersetzt: "Ich möchte das Solarpaneel drehen, weil es eine andere Orientierung habe sollte; weil ich es sauber machen möchte, weil es mein Ziel ist, ein sauberes Solarpaneel zu haben." Das klingt schon sehr vernünftig: Justin kann erklären, was er tut. Genau diese Aufgabe hat Justin übrigens für Alexander Gerst erledigt, als der Astronaut den Roboter 2018 von der International Raumstation (ISS) aus – im Rahmen des METERON-Projekts – fernsteuerte.

Für die Wiedergabe dieses Videos auf Youtube.com ist Ihre Zustimmung zur Speicherung von Daten ('Cookies') erforderlich. Unter Datenschutz-Einstellungen können Sie Ihre Wahl einsehen und verändern.

Beim letzten Knopfdruck sagte Justin: "I don‘t know. Nobody told me". Nun kann Justin sein Handeln nicht mehr erklären. Er war damit beauftragt, das Ziel "sauberes Solarpaneel" zu erreichen. Er wusste, was und wie es zu tun ist. Die Hintergründe für den Auftrag kennt er aber nicht.

Dieses letzte Beispiel zeigt, wo die Grenzen liegen. Unsere Roboter setzen ihre Ziele nicht selbst. Und wenn abends im Labor das Licht ausgeht, stellen sie sich keine Fragen wie "Warum gibt es mich eigentlich?" Dies ist technisch nicht realisierbar und wir möchten das auch gar nicht erreichen. Roboter sollen keine existenziellen Krisen haben, sondern uns bei Aufgaben im All und auf Erden unterstützen. Wenn ein Roboter uns allerdings einfach und einleuchtend erklären kann, was er gerade tut, dann können wir nachvollziehen, ob und wie er die vorgegebenen Ziele erreicht.

Darüber hinaus war mein Ziel bei der Green-Button-Challenge, bei den Mitarbeitern meiner Abteilung ein Bewusstsein und Verständnis dafür zu schaffen, dass Roboter oft gar nicht wissen, was sie tun – geschweige denn im Stande sind, dies zu kommunizieren. In der KI-Forschung nennt man das die "Erklärbarkeit" eines Systems, auch "Explainable Artificial Intelligence" oder "XAI" genannt. Diese Erklärbarkeit ist aber essenziell, wenn wir mit Robotern interagieren und ihnen vertrauen sollen: dies ist die sogenannte "Trustworthy Artificial Intelligence". Möchten Sie mit jemandem zusammenarbeiten, der keine Ahnung hat, was er tut – oder es Ihnen nicht erklären kann?

Eine ungelöste Frage mit langer Geschichte

In der Anfangszeit der KI in den 1950er Jahren war eine der ersten großen Fragen, wie man Wissen in intelligenten Systemen repräsentieren kann. Obwohl die Frage noch lange nicht abschließend beantwortet wurde, ist diese Diskussion heute leider etwas in Vergessenheit geraten – auch wegen des Aufsehens um Deep Learning. Meine Überzeugung ist aber, dass datengetriebene Methoden wenig helfen können, diese Frage zu beantworten. Robotik ist für mich so spannend, weil sie eine Neuauflage und Wiederbelebung der Frage nach Wissensrepräsentation erfordert.

Sie ist einerseits höchst philosophisch: Wenn man sein Handeln erklären und aussprechen kann – wie Justin jetzt – bedeutet es, dass man weiß was man tut? Oder braucht man Bewusstsein – das Justin sicher nicht hat – um etwas wirklich zu wissen? Abgesehen von diesen philosophischen Fragen finde ich die Robotik auch aus pragmatischer Sicht faszinierend, weil unsere KI-Forschung für reale Anwendungsfelder direkt relevant ist: von der Raumfahrtassistenz (wie im METERON-Projekt), über Roboter in der Pflege bis hin zu den Fabriken der Zukunft.

Wir behaupten natürlich nicht, in sieben Tagen eine fast 70 Jahre alte Frage beantwortet zu haben. Die Themen Wissensrepräsentation und Erklärbarkeit stehen weiterhin prominent auf unserer Forschungsagenda, auch über den grünen Knopf hinaus. Nach Abschluss des Wettbewerbs arbeiten wir nun gemeinsam und mit den anderen Abteilungen des Instituts daran, die verschiedenen Lösungen anzusehen, zu verstehen, und zu integrieren.

Schon heute lade ich Sie herzlich zu unseren öffentlichen Veranstaltungen ein, damit unsere Roboter Ihnen selbst erklären können, was sie gerade machen – auf Knopfdruck!