HPDA-Grundlagensoftware

Große Datenmengen reichen alleine nicht aus, um Voraussagen machen zu können. Erst durch die Analyse der Datensätze auf Muster, Strukturen und Regelmäßigkeiten wird es möglich, aus Daten nützliches Wissen zu extrahieren. Zur Datenanalyse werden einerseits klassische statistische und numerische Verfahren eingesetzt, andererseits intelligente Analysemethoden aus dem Bereich des maschinellen Lernens. Die immer größer werdenden Datenmengen führen zu einem Problem in der Datenanalyse. Eine Grundlagensoftware für High Performance Data Analytics (HPDA) soll die Auswertung solcher Datenmengen ermöglichen.

Gemeinsame Softwareplattform im DLR

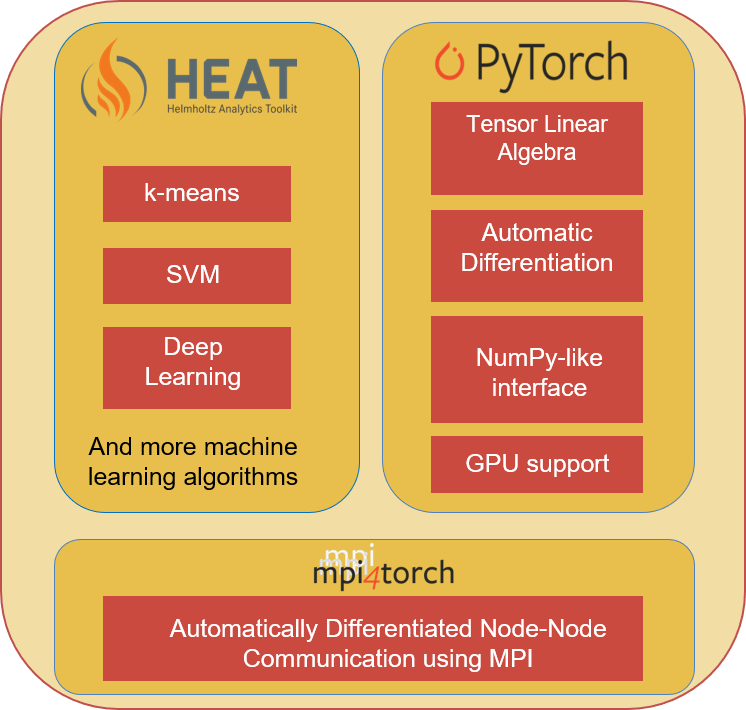

Das Vorhaben HPDA-Grundlagensoftware schafft eine gemeinsame Softwareplattform für die Analyse großer wissenschaftlicher Datensätze am Deutschen Zentrum für Luft- und Raumfahrt (DLR). Dafür stellt die Plattform grundlegende Algorithmen der statistischen und KI-basierten Datenanalyse, der numerischen linearen Algebra sowie schnelle I/O-Bibliotheken für große parallele Rechnersysteme und schnelle Datenspeichersysteme zur Verfügung.

Ein Großteil der Big-Data-Anwendungssoftware im DLR wird separat und aufwendig für die zur Verfügung stehenden Großrechner parallelisiert und optimiert. Aufgrund mit den DLR-Anwendern abstimmten Schnittstellen innerhalb der im Vorhaben geschaffenen Analyseplattform wird eine Zusammenarbeit über Anwendungsgrenzen hinweg deutlich erleichtert.

Das Ziel unseres Vorhabens ist die Entwicklung einer gemeinsam genutzten Softwareplattform für Big-Data-Anwendungen. Diese Anwendungsplattform bildet eine Zwischenschicht zwischen der Anwendung und dem HPDA- bzw. HPC-System.

Aufgrund der Anwendungsbreite wird die Anwendungsplattform notwendigerweise aus mehreren Bibliotheken bestehen, die im Hinblick auf die Nutzung von gemeinsamen Schnittstellen weiterentwickelt werden sollen. Die konkreten Anwendungen werden auf die Grundlagensoftware angepasst, so dass die zeitaufwendige Anwendungsparallelisierung im Idealfall bereits über die Grundlagensoftware vollständig abgedeckt ist.

HEAT basiert intern auf der Open-Source-Software PyTorch, die für das maschinelle Lernen entwickelt ist. HEAT erweitert die Software um den Aspekt der Datenparallelität für Großrechner des High-Performance Computing, unter Nutzung von mpi4torch. Die hochparallelen Algorithmen unterstützen verschiedene Helmholtz-Anwendungen in der Datenanalyse beispielsweise im Bereich von Hochgeschwindigkeitsaufnahmen von Raketentriebwerken.

Softwarebibliotheken der HPDA-Grundlagensoftware

Projektlaufzeit:

- Seit 2022

Projektbeteiligte:

Publikationen zu diesem Projekt auf eLIB:

- HeAT - a Distributed and GPU-accelerated Tensor Framework for Data Analytics

- An Optimized, Parallel Computation of the Ghost Layer for Adaptive Hybrid Forest Meshes

- t8code - Extreme Scale Adaptive Mesh Refinement with Arbitrary Elements

- Scalable algorithms for adaptive mesh refinement with arbitrary element types

- Modularity of Lowlevel Forest-of-octree Libraries

- Lossy compression by adaptive mesh refinement

- Exascale-ready adaptive mesh refinement and applications in Earth system modelling

- Enabling dynamic adaptive mesh refinement (in MESSy) using t8code